Lumos

介绍?

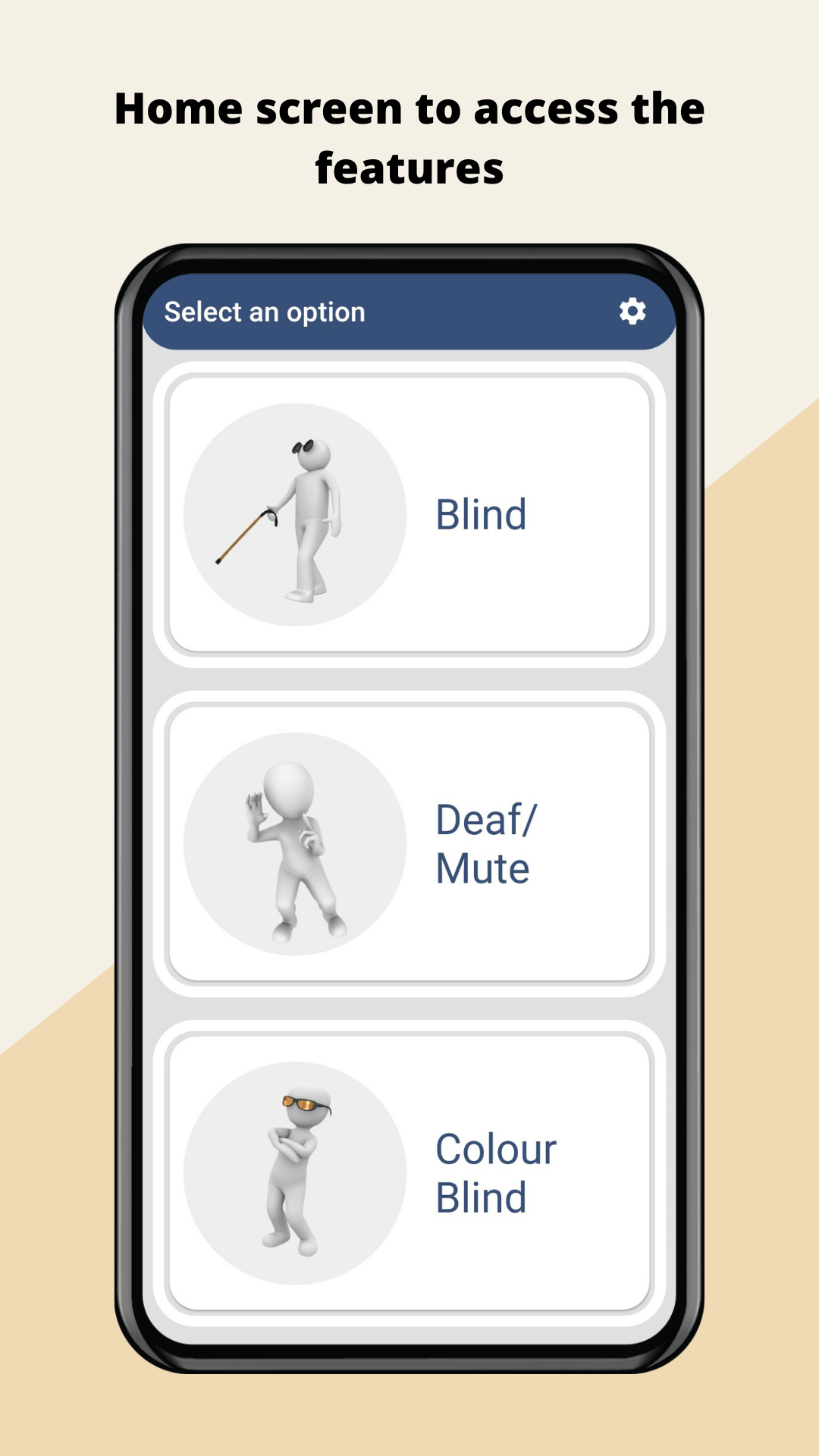

尽管工具和技术不断进步,人类尚未开发出帮助视觉/听觉/言语障碍人士的应用程序。随着能够为“愚钝”的计算机注入“智能”的数据建模技术的兴起,以及易于访问性,这种“智能”可以扩展到我们的智能手机上,以帮助视觉/听觉/言语障碍人士应对周围环境并在日常活动中获得帮助。我们的应用程序旨在利用深度学习的力量,弥合他们与物理世界之间的差距,这种深度学习甚至可以在低端设备上以清晰的用户界面访问,从而使他们能够更好地了解周围的世界。

技术栈?

?构建代码

-

克隆仓库

git clone https://github.com/SilentCruzer/Lumos.git -

打开您喜欢的代码编辑器(VS Code、Android Studio 等)

-

点击“打开现有项目”

-

浏览到克隆仓库的目录,然后单击“确定”

-

让您的代码编辑器导入项目

-

要在终端中安装依赖项,请运行

flutter pub get。 -

通过点击“运行”按钮在您的设备上构建应用程序,或使用模拟器。

?应用程序预览

|

|

|

|---|---|---|

|

|

|

?♂️为什么选择这个项目?

我们这个项目的主要目的是利用和研究深度学习架构以及易于原型化的工具如何帮助我们开发即使在低端设备上也能轻松渲染的应用程序。通过这个应用程序,我们将开发一个一站式解决方案,让盲人或部分视力障碍的人更好地了解周围环境,并能够应对他们面前不断变化的世界。协助聋哑人士与甚至不知道手语的人沟通,并协助色盲人士了解任何物体的确切颜色。

最低可行产品(MVP)将允许用户利用图像字幕架构,通过自然语言处理以清晰的方式进行语音输出,从而对周围环境产生实时洞察。该应用程序的基石将是其用户界面,它将通过易于处理和使用来为用户注入清晰的体验。

对于这个项目,我们将协作处理各个领域,例如

- 使用 tflite 收集数据和训练模型

- 使用 Flutter 原型化移动应用程序

- UI/UX 设计

对于我们团队的所有成员来说,这是一次丰富的经验。

我们的项目如何对视觉/听觉/言语障碍人士更具可访问性

- 从图像标记到货币检测的每项功能,都使用**文本转语音**功能向用户播报检测到的内容?️

- 每个屏幕在打开时**振动的强度都不同**,帮助用户无缝导航。按钮还具有**独特的振动**,以提高可访问性?

- 我们使用的**按钮数量最少**,但现有的按钮**尺寸都很大**。例如,屏幕的上半部分有一个按钮,下半部分是另一个按钮,这样用户**就不需要精确单击**特定位置,从而方便盲人导航应用程序?

- 所有功能**完全离线**运行,无需任何互联网连接?

- 所有功能均**实时**运行,无需预处理时间即可让模型进行预测,因此用户可以获得即时更新?️

- ASL 功能使用简单的用户界面,以便可以快速访问所有功能,并在言语/听觉障碍人士与完全不熟悉 ASL 手语的人之间建立便捷的沟通。此外,还实现了文本转语音功能,使其适用于同时患有听觉障碍和言语障碍的人士?

- 色盲功能也继续使用简单且易于访问的用户界面,以便用户可以轻松获得他们以前无法用肉眼看到的的确切颜色?

?试一试

您可以通过将应用程序安装到自己的设备上来进行测试。APK 可在此处获取 这里。

您也可以在 Appetize.io 上现场试用。我们建议在真实设备上使用该应用程序,因为该应用程序严重依赖于设备相机。

?资源

如果您这是您的第一个 Flutter 项目,这里有一些入门资源

有关开始使用 Flutter 的帮助,请参阅 在线文档,其中提供了教程、

示例、移动开发指南和完整的 API 参考。

团队 Divergent ✨

感谢这些出色的人(表情符号键)

Adithya Kumar ? ? ? |

Yash Khare ? ??? |

Akshat Tripathi ? ? ? |

Aman Kumar Singh ? ? ? |